|

Teoria informacji to dział matematyki na pograniczu statystyki i informatyki, mający również olbrzymie znaczenie w współczesnej telekomunikacji, dotyczący przetwarzania informacji oraz jej transmisji, kompresji, kryptografii itd.

Za ojca teorii informacji uważa się Claude'a E. Shannona, który prawdopodobnie po raz pierwszy użył tego terminu w 1945 roku, w swojej pracy zatytułowanej "A Mathematical Theory of Cryptography". Natomiast w 1948 roku, w kolejnej pracy pt. "A Mathematical Theory of Communication" przedstawił najważniejsze zagadnienia związane z tą dziedziną nauki.

Ważne pojęcia teorii informacji:

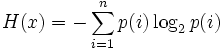

Wzór na entropię to:

Source: Wiki

|